Обзор Nvidia Geforce GTX 660 Ti: характеристики, тесты, разгон

Сборка бюджетного компьютера начинается с выбора видеокарты. Если современные видеоускорители трудно назвать дешевыми, то модели, вышедшие 3-5 лет назад подходят под категорию бюджетных. Одной из таких видеокарт считается Nvidia Geforce GTX 660 Ti, вышедшая в 2012 году.

Даже несмотря на год выпуска, она все еще актуальна при сборках ПК и способна справиться с запуском современных игр на средних и низких настройках.

Технические параметры

Рассмотрим более подробно технические характеристики GTX 660 Ti, чтобы убедиться в актуальности видеокарты:

- Видеоускоритель работает на основе чипа GK104 с 28-нанометровым техпроцессом.

- Средняя частота ядра колеблется между 915 МГц и 1050 МГц.

- Площадь ядра – 294 мм2.

- Число установленных транзисторов – 3500 млн. штук.

- Система охлаждения – двухслотовая.

- Блоков рендеринга – 24, текстурных блоков – 112.

- Энергопотребление находится на уровне 150 Вт.

- Шина памяти – 192 бит.

- Объем видеопамяти 2 Гб GDDR5 с пропускной способностью 114 Гбайт/с и частотой 6008 МГц.

Мощностей видеокарты достаточно для использования в современных игра и программах. Этот вывод можно сделать на основе анализа технических характеристик Nvidia Geforce GTX 660 Ti.

Обзор видеокарты

Рассмотрев технические характеристики модели, стоит сделать общий обзор GTX 660 Ti: рассмотреть оптимальные модели процессоров, блока питания и т.д.

Потребление энергии видеокарты – 150 Вт. В качестве блока питания производители рекомендуют модели с объемом 450 Вт. Указанной мощности будет достаточно для данного видеоускорителя в связке с большим объемом оперативной памяти и мощным процессором.

Чтобы раскрыть GTX 660 Ti по максимуму, стоит подобрать мощный процессор. Отличным выбором станут чипы от компании Intel, начиная от моделей i3. Идеальный вариант – это Intel Core i5. С ним видеокарта раскроет все свои возможности в современных играх и требовательных к ресурсам программах.

Рабочая температура этой модели – 85 градусов. Максимальный нагрев возможен до 95-100 градусов.

Как разогнать видеокарту Nvidia Geforce GTX 660 Ti

За увеличение производительности отвечает разгон GTX 660 Ti. Этот процесс позволяет увеличить стандартные технические параметры.

Для осуществления разгона понадобится три программы:

- MSI Afterburner. Утилита отвечает за процесс увеличения показателей.

- Funmark. Позволяет производить стресс-тест видеокарты для обнаружения неисправностей.

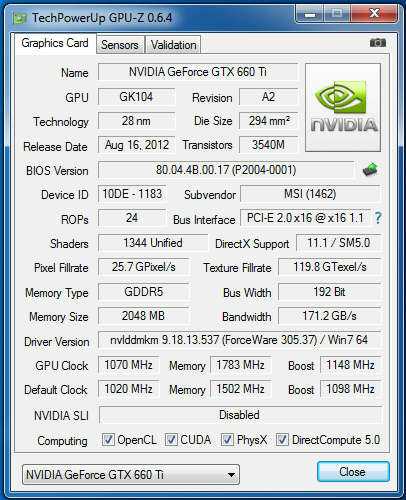

- GPU-Z. С помощью этого софта можно посмотреть финальный результат увеличенных показателей.

Запустив программу MSI Afterburner, нужно увеличить два показателя в интерфейсе: Memory Clock и Core Clock. Первый отвечает за ядро ГП (графического процессора), второй – за частоту памяти процессора.

Показатель частоты ядра повышаем до 900-910 MHz, частоту памяти – до 2000 MHz. Главное при разгоне – повышать эти пункты по 10-20 MHz за один раз, не более. Это нужно для того, чтобы избежать возникновение неполадок в работе видеоускорителя.

По завершении разгона проводим стресс-тест с помощью утилиты Funmark. Если программа обнаружила сбои в работе, то в таком случае следует понизить увеличенные показатели на 10-15%.

Полученные данные отобразятся в программе GPU-Z. Этих параметров будет достаточно ни только для тяжелых игр и программ, но и для майнинга на GTX 660 Ti.

Тесты в играх

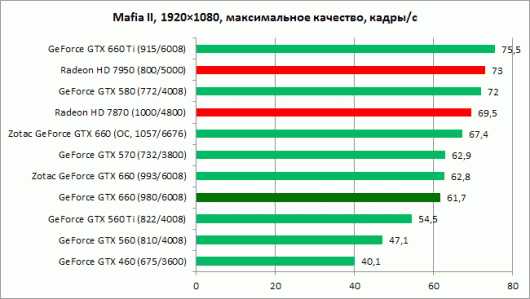

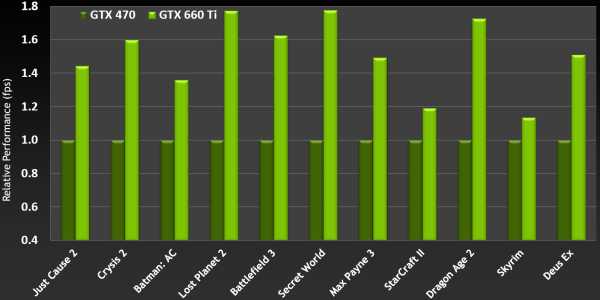

Тестирование видеокарты было произведено в самых современных и требовательных играх на сегодняшний день. За время тестов получились следующие показатели.

Assassin’s Creed: Origins. Игра очень требовательна к железу. Мощностей видеокарты достаточно для запуска игры на минимальном качестве графики. Средний показатель количества кадров – 24. Этого вполне достаточно для максимально комфортной игры. Во время игрового процесса серьезных фризов и лагов обнаружено не было.

The Witcher 3. Игра запускалась на средних настройках в формате FullHD. Минимальное количество FPS составило 24 кадра в секунду. В среднем, этот показатель находился на уровне 27-28. В местах с огромным заселением объектов наблюдались небольшие, но не критичные фризы.

Battlefield 1. В режиме кампании на средних настройках FPS колебался от 25 до 35 кадров в секунду. Во время баталий фризов и лагов обнаружено не было. При увеличении качества графики до высоких настроек число кадров составляло 23 FPS.

Grand Theft Auto 5. На средних настройках в формате FullHD GTA V показывал стабильные 30-35 FPS. Серьезных просадок не наблюдалось, даже во время экшен-сцен. К сожалению, для игры на максимальных настройках видеопамяти GTX 660 Ti недостаточно. Появляются фризы и лаги.

Watch Dogs 2. Игра имеет небольшие проблемы с оптимизаций на ПК. Из-за этого она очень требовательна в плане системных характеристик. При запуске WD 2 на GTX 660 Ti на средних настройках FPS равнялся 20-25 кадрам. При уменьшении настроек до минимальных – 25-30.

Dishonored 2. На среднем качестве графики показатель FPS не опускался ниже 25 кадров. Максимальное число достигало 27.

Следует вывод, что технических параметров этой модели видеокарты достаточно для комфортной игры в современные игровые проекты на средних настройках графики.

Сравнение производителей

У видеокарты GTX 660 Ti имеется 5 разных производителей. Для того чтобы сделать выбор в пользу одного из них, нужно сравнить все характеристики на наличие различий в технических параметрах.

| Производитель | Gigabyte | Asus | Palit | Zotac | MSI |

|---|---|---|---|---|---|

| GPU | GK104 | GK104 | GK104 | GK104 | GK104 |

| Охлаждение | DirectCU II | DirectCU II | DirectCU II | DirectCU II | DirectCU II |

| Техпроцесс | 28 нм | 28 нм | 28 нм | 28 нм | 28 нм |

| Число транзисторов | 3500 млн, шт | 3500 млн, шт | 3500 млн, шт | 3500 млн, шт | 3500 млн, шт |

| Площадь кристалла (мм2) | 294 | 294 | 294 | 294 | 294 |

| Число потоковых мультипроцессоров | 1344 | 1344 | 1344 | 1344 | 1344 |

| Тактовая частота шейдерного домена (МГц) | 915 | 915 | 915 | 915 | 915 |

| Объем видеопамяти (Мбайт) | 2048 | 2048 | 2048 | 2048 | 2048 |

| Тип видеопамяти | GDDR5 | GDDR5 | GDDR5 | GDDR5 | GDDR5 |

| Частота GPU (МГц) | 1032 | 915 | 1006 | 1033 | 1019 |

| Предельная температура процессора (°С) | 100 | 100 | 100 | 100 | 100 |

| DirectX | 11.01.2018 | 11.01.2018 | 11.01.2018 | 11.01.2018 | 11.01.2018 |

| Ширина шины | 256 бит | 256 бит | 256 бит | 256 бит | 256 бит |

| Эффективная частота памяти | 6008 Мбайт | 6008 Мбайт | 6008 Мбайт | 6008 Мбайт | 6008 Мбайт |

| Пропускная способность(Гбайт/c) | 114 | 114 | 114 | 114 | 114 |

| Цена Geforce 660 Ti | 6890р. | 6350р. | 6120р. | 6720р. | 6210р. |

Единственные отличия в технических параметрах между производителями – это тактовая частота чипа. Показатель в 915 МГц принадлежит модели от компании Asus, он является минимальным. Максимальный – 1302 МГц – компании Gigabyte.

Скачать драйвера

Обновление драйверов позволяет увеличивать производительность видеоускорителя в играх и программах. Скачать бесплатно драйвер для видеокарты Nvidia Geforce GTX 660 Ti можно на официальном сайте компании или у нас, перейдя по ссылке.

Новые версии выходят каждые 2-3 месяца. Чтобы не пропускать их релиз, можно установить специальную программу Geforce Experience все с того же сайта Nvidia. Утилита оповещает пользователей о необходимости обновить видеодрайвер, а также позволяет установить оптимальные настройки графики в игре.

Для Windows 7, 8.1, 8 и Vista

Для Windows 10

Размер файла: ~400.00 МБВерсия драйвера: 391.35 (WHQL) от 27.03.2018;

Язык: Русский

Операционная система: Windows 10 32/64-bit, Windows 7 32/64-bit, Windows 8.1 32/64-bit, Windows 8 32/64-bit, Windows Vista

На что способна видеокарта 2012 года в современных играх: Видео

Вконтакте

Одноклассники

Оценка статьи:

Загрузка…videocard.pro

Долгожданный Kepler для масс, обзор и тестирование ASUS GeForce GTX 660 Ti DirectCU II TOP

Разгон видеокарты ASUS GeForce GTX 660 Ti DirectCU II TOP

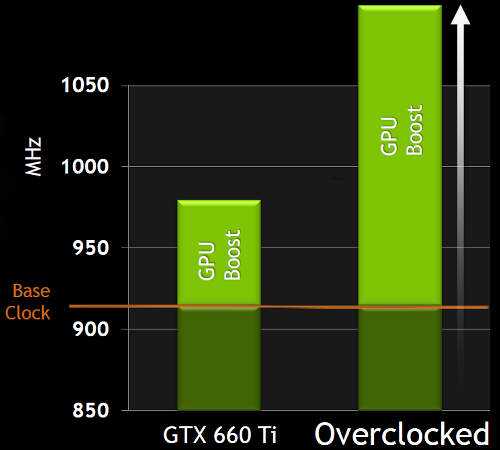

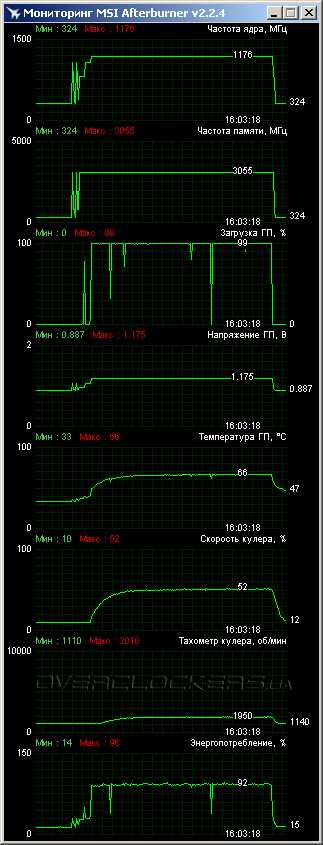

Чем разгонялась карточка — не ясно, но напряжение не менялось, да и логику управления вентиляторами не трогали. В итоге был достигнут следующий результат: 1115/6960МГц (ядро/память):

Итог таков — по ядру карточку удалось погнать на 5%, а по памяти — на 16%.

Далее нам показали табличку, по которой становится ясно, как погнались те или иные карты на основе одних и тех же графических чипов:

| Сравнение разгона видеокарт | |||

|---|---|---|---|

| Максимальная частота ядра | Максимальная частота памяти | Производительность в разгоне | |

| ASUS GTX 660 Ti DC II | 1115 МГц | 1740 МГц | 66.6 FPS |

| Palit GTX 660 Ti JetStream | 1150 МГц | 1795 МГц | 69.0 FPS |

| MSI GTX 660 Ti Power Edition | 1075 МГц | 1800 МГц | 69.1 FPS |

| ZOTAC GTX 660 Ti Amp! Edition | 1115 МГц | 1740 МГц | 66.6 FPS |

Полезная табличка, как и всегда. Однако, стоит держать в уме золотое правило — «разгон = лотерея».

По табличке ниже можно понять, как сильно оверклокерские манипуляции повлияли на производительность видеокарты ASUS (на примере игры Battlefield 3):

Рост производительности за счёт разгона составил 9.7%.

А теперь посмотрим на то, как увеличились температуры у ASUS GeForce GTX 660 Ti DirectCU II TOP в разгоне:

Разница в 1 градус по Цельсию, тут не о чем беспокоиться.

Далее следует таблица сравнения температур видеокарт от разных производителей:

| Сравнение температуры графического ядра | ||

|---|---|---|

| Простой | Нагрузка | |

| ASUS GTX 660 Ti DC II | 35°C | 70°C |

| Palit GTX 660 Ti JetStream | 38°C | 73°C |

| MSI GTX 660 Ti Power Edition | 32°C | 73°C |

| ZOTAC GTX 660 Ti Amp! Edition | 37°C | 70°C |

ASUS GeForce GTX 660 Ti DirectCU II TOP, как и многие другие видеокарты под разными видами нагрузки, выставляет особые частоты и напряжения, вот соответствующая табличка:

| Частота ядра | Частота памяти | Напряжение на GPU (основано на замерах) |

|

| Режим 2D (карта в простое) | 324 МГц | 162 МГц | 0.99 V |

| Мультимониторная конфигурация | 324 МГц | 162 МГц | 0.99 V |

| Воспроизведение Blu-ray | 324 МГц | 162 МГц | 0.99 V |

| Режим 3D (карта в нагрузке) | 1055- 1260 МГц | 1502 МГц | 1.000 — 1.175 V |

www.u-sm.ru

Обзор и тестирование видеокарты ASUS GTX660 TI-DC2O-2GD5 / Overclockers.ua

Героем данного обзора станет еще один видеоадаптер ASUS из серии GeForce GTX 660 Ti. В конце прошлого года мы рассмотрели модель GTX660 TI-DC2-2GD5. Карта оказалась невероятно тихой и порадовала отличным разгоном. Теперь мы познакомимся с версией DC2O, которая изначально работает на повышенных частотах. Но сумеет ли старшая модель обойти младшую по разгону и чем-то удивить кроме заводского разгона? Это мы сейчас и выясним. ASUS GTX660 TI-DC2O-2GD5Поставляется в массивной коробке. Дизайн упаковки полностью повторяет внешний вид других GeForce от ASUS.

Комплект поставки следующий:

- переходник DVI/D-Sub;

- переходник питания с двух molex на PCI-E 6pin;

- диск с программным обеспечением;

- инструкция.

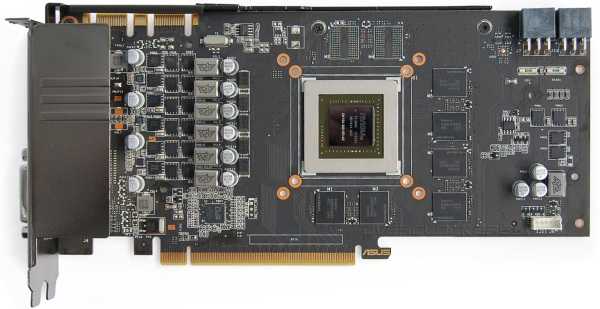

Кожух кулера имеет волнистую поверхность и характерные красные вставки, что является обязательным элементом внешнего дизайна всех топовых продуктов ASUS.

Массивная система охлаждения выступает за пределы платы. Сбоку прикручено ребро жесткости. Обращает на себя внимание нестандартное расположение разъемов питания. Они развернуты на 180° так, что фиксатор кабеля оказывается вверху (в этом месте на текстолите есть вырезы). Это сделано для упрощения подключения кабелей питания, ведь при стандартном расположении разъемов массивный кулер оставляет мало свободного места, чтобы пользователь мог достать защелки пальцами.

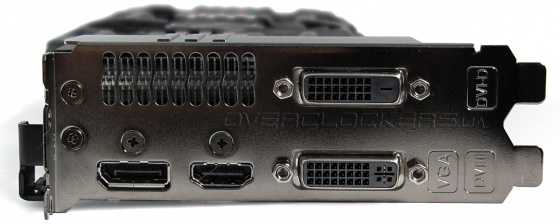

На заднюю панель выведены HDMI, Display Port и два DVI.

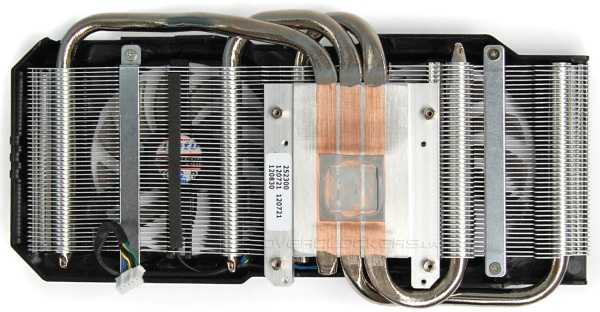

Кулер нам хорошо знаком. Он охлаждает как GTX660 TI-DC2-2GD5 //www.overclockers.ua/video/geforce-gtx660ti-asus-dc2/, так и старшие карты — GTX670-DC2T-2GD5 //www.overclockers.ua/video/geforce-gtx670-asus-dc2t/, GTX670-DC2-2GD5 //www.overclockers.ua/video/geforce-gtx670-asus-dc2/. Три мощные тепловые трубки напрямую отводят тепло от графического кристалла.

Изгибаясь, трубки пронизывают массив тонких алюминиевых пластин.

Обдувается радиатор парой 80-мм вентиляторов FirstD FD7010h22S.

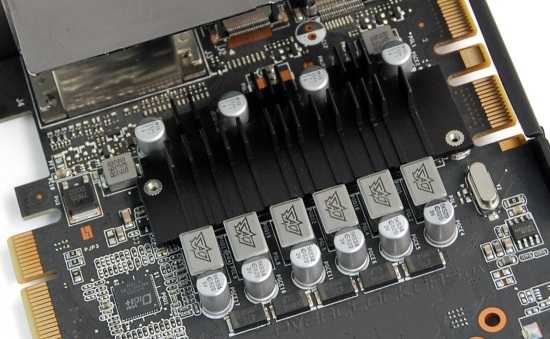

Силовые элементы накрыты отдельным небольшим радиатором.

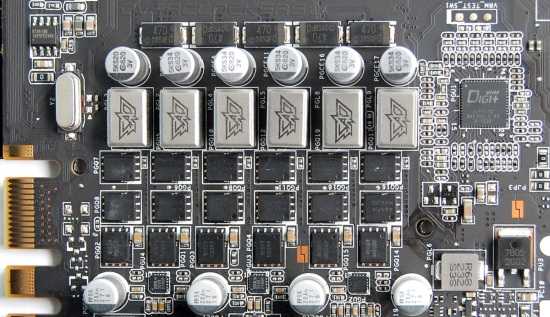

Дизайн платы нереференсный, но отличий от младшего собрата GTX660 TI-DC2-2GD5 нет. Видеокарта выполнена по технологии Super Alloy Power, что предусматривает использование высококачественных элементов.

Если у обычного GeForce GTX 660 Ti на питание GPU идет четыре фазы, то у данной карты реализовано шесть. Управляющие функции возложены на контроллер Digi+ ASP1212.

Графический чип GK104-300-KD-A2 от процессора GeForce GTX 670 отличается урезанной до 192 бит шиной памяти и меньшим числом блоков ROP.

Два гигабайта памяти набраны восемью микросхемами Hynix H5GQ2h34AFR R0C.

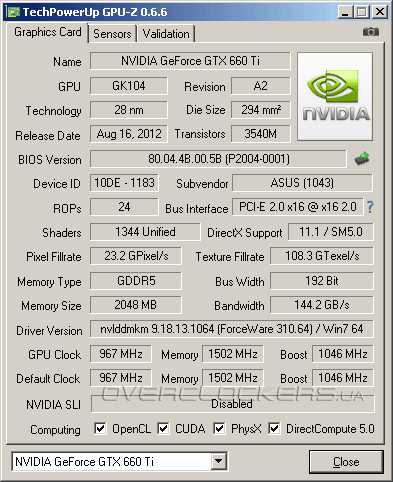

Заводской разгон у ASUS GTX660 TI-DC2O-2GD5 коснулся лишь частоты ядра. Базовая частота повышена до 967 МГц при Boost Clock в 1046 МГц. Память функционирует на предписанных 6008 МГц.

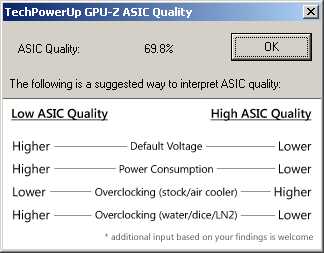

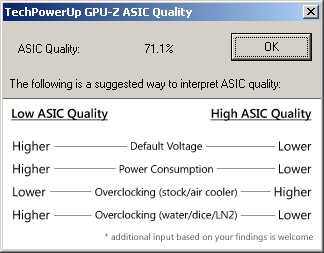

Согласно GPU-Z у данного графического чипа ASIC Quality равен 69,8%.

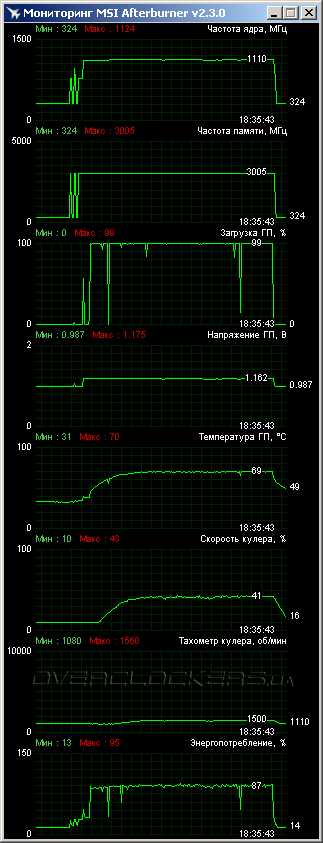

Наш 12-минутный тест Crysis: Warhead на максимальном качестве графики не смог прогреть карту свыше 70 °C при 23 °C в помещении. Скорость вращения вентиляторов достигала 1500 об/мин. ASUS GTX660 TI-DC2-2GD5 в аналогичных условиях был немного тише и холоднее. Впрочем, и к данному видеоадаптеру не придраться. Особенно это касается шума. Мы не раз упоминали, что у новой версии двухслотового кулера DirectCU II вентиляторы тихие даже при 2000 об/мин, так что при 1500 об/мин GTX660 TI-DC2O-2GD5 устроит даже самого требовательного пользователя.

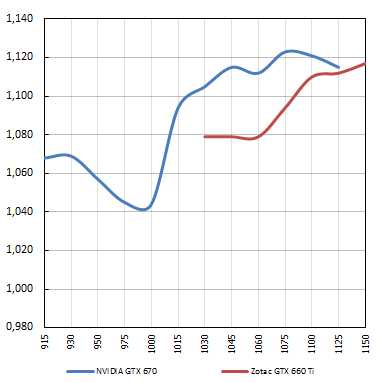

При заявленном официальном Boost Clock в 1046 МГц максимальная частота достигала 1124 МГц. Изначально карта стартовала на 1110 МГц, через некоторое время, ускоряясь до 1124 МГц. И по такой схеме GPU работал во всех тестовых приложениях. Даже в Crysis 2 частота не падала ниже отметки в 1110 МГц, а именно в этой игре мы всегда фиксируем наибольшие просадки у кар

www.overclockers.ua

Методика надежного разгона geforce gtx660 через редактирование биоса видеокарты

В этой заметке поставлено задачу раскрыть один из вариантов методики разгона видеокарт GeForce GTX660 (но ее можно применить и к другим моделям семейства Kepler) на основе редактирования и подальшей прошивки биоса видеокарт. Все подходы и этапы проверялись лично, неоднократной прошивкой биоса на КFA2 GTX660 EX OC PCI-E 2GB. Вопросы самой прошивки не входят в круг задач этой заметки.

Для анализа биоса видеокарты используем Kepler Bios Tweaker 1.25

[http://www.hardwareluxx.de/community/f305/nvidia-geforce-gtx-600-serie-bios-files-932143.html]. Для анализа потенциала разгона в операционной системе удобно использовать Nvidia Inspector. С этих утилит будем использовать терминологию для заметки. ASIC видеокарты считывается в GPU-Z.

Сначала немного азов. У 660-й есть ФИЗИЧЕСКИЙ лимит ограничения потребления 146 Вт, превысить который невозможно (в теории 150 Вт = 75 Вт с шины pci-e + 75Вт с 2х3 пин конектора). 39 страница сего стандарта:

http://www.pcisig.com/developers/main/training_materials/get_document?doc_id=b590ba08170074a537626a7a601aa04b52bc3fec

Лимит потребляет как GPU, так и память. Так что при разгоне чего-то одного экстремально, страдает разгон другого компонента.

Этот лимит видно как Max (mW) в правом столбце в Kepler Bios Tweaker. Увеличение его свыше 146Вт ничего не дает для прироста производительности и стабильности, проверено экспериментально. Он зашит в большинстве заводских биосов, исключение – MSI GeForce GTX 660 HAWK и Inno3D iChill HerculeZ GeForce GTX 660.

Этот предел потребления достигается на среднем ASIC (74 %) уже при 1187,5 мВ на 1202 Мгц и частоте памяти в 6600Мгц в среднем. С высшим ASIC частотный потенциал чипа выше.

Качество разгона (результаты в синтетике, провалы фпс) зависят от ровности условной линии удержания частоты/вольтажа при софтовом мониторинге (в реальной нагрузке – отсутствие микропровалов частоты буста). Важен также и мониторинг потребления, его линия также должна быть без сильних провалов (но может колебаться, в зависимости от нагрузки, то есть должна менятся синхронно с кривой нагрузки GPU). Ниже приведен пример идеально ровной линии частоты буста.

Если при ровной (однотипной) нагрузке на GPU есть провалы частоты– такой разгон – «коту под хвост».

Пример неправильной линии потребления показан ниже (бывает если прошить выше 146Вт в правом столбце, или, если выходить за физический лимит слишком высокой комбинацией вольтажа + частоты для каждого отдельного потенциала ASIC).

В левом столбце зашиты софтовые ограничители лимита потребления.

Они нужны для ручного увеличения или уменьшения лимита через драйвер в софте.

Разработчики их используют, чтоб варьировать производительность для разных моделей 660-ых. Значения в левом столбце (софтовые) не должны превышать значения в правом (физические).

Рассмотрим факторы, влияющие на производительность GPU. Она зависит от ровности удержания частоты реального буста (для избежания путаницы используем термин из Nvidia Inspector — EST MAX

Для того чтобы добится увеличения EST MAX нужно сначала снять ограничения буста. Можно начать с выставления Boost Limit на 1280,5 Мгц (проверено эмпирическим путем для ASIC 74, 5%).

Буст сдвигается шагами в 13Мгц и привязан к вольтажу, который тоже повышается с шагом в 12,5мВ в соответствии с конкретными ячейками таблицы Max Table Clock. Таблица у нас на GTX660 имеет диапазон 25 ячеек (оранжевый цвет).

Важно! Чтобы получить дефолтный диапазон в 25 ячеек (нужно в Kepler Bios Tweaker сдвинуть ползунок Max Table Clock в третьей вкладке максимально влево до значения 1202,0 Мгц и нажать кнопку “Save Bios” (спасибо комраду ZETTER за подсказку).

Алгоритм буста семества кеплер работает так, что, задав соответствующий вольтаж (при снятом лимите буста), можно выйти на желаемый «реальный буст» EST MAX, который прописан в соответсвующей ячейке частот Table Clocks.

Далее следует начать подбирать вольтаж. Вольтаж задается как среднее число от комбинации вольтажей Max Voltage # 1 и Max Voltage # 2.

Для удобства воспользуемся ориентировочной таблицей (зависит от ASIC- может отклонятся на шаг в большую или меньшую сторону), за основу взята таблица комрада ZETTER

[ https://forums.overclockers.ru/viewtopic.php?p=10817825#p10817825 ]

Но рассчитана на основе моей видеокарты KFA2 GTX 660 EX OC с ASIC (74.5%).

Значения от 1137 мВ зашивались в биос на практике. Ниже 1137 шить вольтаж не было смысла.

Приметка. В таблице взят реальный диапазон нужный для разгона. Значения можно продолжить вплоть до 25 шага вниз. Нужно обратить внимание на тот факт, что после 38 ячейки и выставления вольтажа в 1,200 В идет скачек сразу к 43 ячейке (может варьироваться в зависимости от карты). Для урезания такого большого скачка есть на первой вкладке Kepler Bios Tweaker «Boost Limit». При его помощи можно урезать большой скачек, но можно и сдвинуть вниз диапазон в Max Table Clock).

Можно менять и Max Voltage # 1, тогда Real Voltage (soft monitored) тоже будет снижаться кратно 12,5мВ. Max Voltage # 1 можно изменить в онлайн редакторе

[ http://www.v3dt.com/nvidia/600/ ] или, воспользовавшись KGB — Kepler BIOS Editor/Unlocker

[ http://www.xtremesystems.org/forums/showthread.php?284014-KGB-Kepler-BIOS-Editor-Unlocker ] Можно зашить два одинаковых значения в Max Voltage # 1 и Max Voltage # 2, но это немного ухудшает стабильность, так как есть возможность при конкретном вольтаже при среднем ASIC (74%) выходить на буст на две ячейки выше сдвигом еще далее в Max Table Clock.

Пример для 1150 мВ и EST MAX 1150 Мгц

Если в примере выше сдвинуть Max Table Clock до 1306,5 Мгц, – EST MAX сдвинется до значения в той же 34 ячейке, но уже 1176 Мгц, то есть разница между вольтажем и частотой уже составит 26 единиц. Она не всегда стабильно держится, возможна ошибка «вылета» драйвера.

Для увеличения стабильности при таком сдвиге, можно добавлять (выявлено эмпирическим путем) вольтаж в стейты P00 и Р02 (low 3D), например 987,5 mV. Эти же вольтажи P00 и Р02 (low 3D) можно добавить и без прошивки в биосе, а в софте. Софтовое поднятие вольтажа работает только на этих состояниях, к сожалению, а не с Max Voltage.

Все эти изменения касаются подбора буста и вольтажа, но следующая задача удержать этот буст без микропровалов в реальных приложениях и ровной линией в мониторинге. Здесь нужно выствить правильный лимит питания в биосе на левой вкладке Power Control.

Напомню, что на потребление видеокарты влияет и частота работы набортной памяти.

Можно выставить Def (mW) — 100%, к примеру 126500 мВт, а Мах (mW) поднять вплоть до дефолтного значения в правом столбце физического Def (mW) 143500. Выше нету смысла, так как физический лимит среднестатистической GTX660 = 146Вт. После прошивки таких значений можно в софте поднимать лимит (Msi afterburner, EVGA PrecisionX итд.), ища нужный. Но можно (как и я сделал, после долгих проверок на практике) поставить Def (mW) в 139500мВт (память 6932 Мгц).

Преимущество такого подхода в том, что карта сама возьмет нужный процент от этого лимита при определенной нагрузке.

На нагрев VRM лимит практически не влияет. Влияет комбинация вольтажа/частоты.

Разгон памяти сугубо индивидуален, но частота 6400 Мгц покоряется практически всем GK-106. Не забывайте, что высокие частоты памяти отъедают потенциал разгона чипа, так как «NVIDIA традиционно не разделяет питание MEM и PLL с помощью отдельного ШИМ-контроллера» [Дмитрий Владимирович].

Вопросы способа прошивки биоса не входят в задачи этой заметки, но сложностей с этим никаких не возникает. Флеш биоса GK-106 рассчитан на тысячи перезаписей. Сам прошил свой раз 60, экспериментируя. Никакой деградации не заметил. Но за ущереб вашим видеокартам при неправильных действиях при прошивке биоса (отключение электичества при прошивке), я ответственности не несу.

Есть еще вариант поднятия частот буста форсированием нижнего базового диапзона частоты.

Но нам он не подходит так как это значение будет и использоваться для low 3D (ускорение просмотра видео, флеш итд). Там такие высокие частоты лишние.

Спасибо комрадам zetter, Lsdmax, TwinkE, а также всем другим фанам GK-106 из ветки «Все о GeForce GTX 660/650Ti (GK106. Kepler 28nm)» за идеи и совместные эксперименты.

overclockers.ru

Обзор и тестирование видеокарты ZOTAC GTX 660 Ti AMP! Edition (страница 2)

Разгон

Несмотря на всю веру простых покупателей в GPU Boost (как в превосходную систему авторазгона для новичков), я склонен полагать, что оверклокерам она будет только мешать. Тому есть несколько причин, а присутствие новой технологии во всей линейке видеокарт NVIDIA лишь раздражает энтузиастов. Но все же придется разбираться, как она работает. Отдельный вопрос, как совмещать пару или более видеокарт разных производителей с разными частотами в SLI конфигурациях…

Встроенный алгоритм управления частотой и напряжением графического процессора работает по своим стандартам, и разгон Kepler осуществляется несколько в ином формате. Обращаю ваше внимание, что сейчас в руки пользователей попадает несколько переменных.

Первая — предельное энергопотребление, стандартная формулировка которого обозначается цифрой 100% или ~150 Вт для карты целиком (может варьироваться в зависимости от экземпляра, в основном завышенное базовое значение используется в разогнанных с завода видеокартах). Отныне частота 915 МГц для GTX 660 Ti – это базовая частота, ниже которой графическое ядро не опускается ни при каких нагрузках. Будь то Furmark, либо любой другой экстремальный тест. Значение «Турбо» (GPU Boost) – 980 МГц, обозначает усредненную частоту GPU по результатам большинства игровых сцен.

Новая технология, ориентируясь на максимально допустимую нагрузку и достигнутую температуру, автоматически подстраивает частоту и задает напряжение. В теории максимальная температура равна 82-85°C, вентилятор системы охлаждения постоянно подстраивается под изменяющиеся условия тестирования, не позволяя GPU разогреться выше приведенных чисел. Естественно, что GPU Boost учитывает и температуру. И если видеокарта по каким-то причинам превысит эту цифру, то в дело вступят функции защиты. Практический максимум, по заявлениям NVIDIA, равен 98°C – это критическая температура, после которой система может полностью выключиться, предварительно применив все доступные методы защиты.

Вторая – это желаемая частота. Я не пишу «базовая», поскольку при установке этой частоты можно поймать себя в ловушку. Все дело в том, что при значительном нагреве или в случае аномальной загрузки видеокарта может понижать данную частоту и ниже ваших установок.

Разгон стоит начинать со статичного предельного энергопотребления, например, 100%. Затем понемногу увеличиваете желаемую частоту — до тех пор, пока не увидите один из признаков достижения лимита. Видеокарта либо начнет сбрасывать частоты на начальные значения, либо зависать. Любой из этих признаков означает, что придется увеличивать предел. Не советую сразу бросаться на амбразуру и выставлять максимально допустимое энергопотребление. Данное действие мгновенно приведет к перегреву и зависанию карты. Зато набравшись терпения, чутья и времени, вы гарантированно мелкими шажками разгоните карту до 1.2-1.3 ГГц.

В свою очередь GPU Boost автоматически добавляет напряжение в зависимости от выставленного предела энергопотребления, следом растет и частота. В конечном итоге видеокарта постепенно разгоняется. В чем же суть обоих инструментов управления? Не в том ли, что отныне нет смысла задавать базовую частоту и напряжение? Фактически, испробовав различные комбинации и варианты, мне удалось сбалансировать на грани фола и удержать хороший разгон во время проверки программой Furmark. Делается это двумя переменными. Необходимо тонко чувствовать работу GPU Boost и подстраиваться под нее, устанавливая правильную базовую частоту и предел энергопотребления.

К счастью, видеокарты оригинального дизайна получили расширенный диапазон регулировки Power Target — до 150 и более процентов. Но это применимо не всегда, часть ускорителей (особенно тех, что заранее разогнаны), наоборот, ограничена до 120%. Тут логичнее говорить об общем максимуме мощности системы питания, когда каждый производитель выставляет свой предел.

В отдельных случаях приходится менять подход к разгону графических карт GeForce GTX 660 Ti/ GTX 670/ GTX 680. Связано это с тем, что производитель закладывает в выставленное по умолчанию энергопотребление фактический потолок работы видеокарты. На таких картах превышение определенной частоты приводит к срабатыванию защиты по энергопотреблению, и разгон превращается в антиразгон. В таком случае сначала необходимо увеличить Power Target, а уж затем наращивать частоту.

Говоря проще, Power Target указывает на максимальное энергопотребление видеокарты, под которое подстраиваются Turbo Boost и ваши настройки разгона. Чем выше значение Power Target, тем больше шансов разогнать GPU, при условии нормальных температур графического ядра и силовой части. Как только вы упираетесь в верхнюю грань и параллельно пытаетесь задать большую частоту (нежели ту, на которой может работать видеокарта), алгоритм, заложенный в драйвера, сбрасывает частоту. После этого достаточно убрать с десяток мегагерц и повторить тест. И так до тех пор, пока не найдете максимально стабильную частоту ядра. А далее — новый маневр с Power Target. Совет здесь один — поднимать на одно-два деления и не забывать при этом о проверке работоспособности видеокарты на заданных параметрах.

Потенциал графического ядра в зависимости от подаваемого на него напряжения.

Независимо от качества и типа цепи питания система на GTX 670 устроена так, что с ростом частоты алгоритм GPU Boost подавляет рост напряжения. Когда графический процессор упирается в определенную частоту, ШИМ-контроллеру в рамках допустимого энергопотребления дается некоторая свобода, и уровень резко возрастает. Далее следуют три состояния: снова падение, как в случае с референсной картой NV

overclockers.ru

GTX660-DC2T-2GD5 — лучший GeForce GTX 660 от ASUS / Overclockers.ua

Недавно мы познакомились с нестандартным GeForce GTX 660 в исполнении KFA². Несмотря на улучшенный дизайн печатной платы и мощное охлаждение этот видеоадаптер не смог продемонстрировать выдающихся результатов разгона. И это очередной раз подтвердило наше убеждение о сильно ограниченном частотном потенциале GeForce GTX 660. Посмотрим, сумеет ли удивить адаптер ASUS GTX660-DC2T-2GD5, который изначально работает на частотах GPU, едва достижимых другими GeForce при разгоне. Так что без лишних слов приступаем к обзору.ASUS GTX660-DC2T-2GD5

Поставляется в крупной коробке с оформлением, характерным для всех GeForce от ASUS.

Видеокарта внешне повторяет ASUS GTX660 TI-DC2-2GD5. Используется такая же двухслотовая система охлаждения с толстыми тепловыми трубками.

Печатная плата у младшей версии немного длиннее, чем у упомянутого GeForce GTX 660 Ti. Присутствует лишь один разъем под SLI. Сбоку прикручено ребро жесткости.

Набор разъемов на задней панели стандартен: два DVI, один HDMI и DisplayPort.

Кулер использует три тепловые трубки, которые напрямую контактируют с поверхностью графического чипа. Но из-за небольших размеров GPU GK106 площадь контакта с боковыми трубками небольшая. На массивном основании есть термопрокладка, которая контактирует с двумя микросхемами памяти. Не совсем понятно, зачем это нужно, ведь все остальные микросхемы GDDR5 радиаторов не имеют.

Расположение пластин очень плотное другу к другу. Верхняя грань у половины пластин имеет небольшой вырез, что потенциально должно создавать меньше препятствий воздушному потоку и улучшить продуваемость всей поверхности пластин при низких оборотах вентиляторов.

За обдув отвечает пара вентиляторов FirstD FD7010h22S диаметром 80 мм (реальный диаметр крыльчатки немного меньше).

Печатная плата нестандартного дизайна. Несмотря на большие размеры платы в сравнении с референсной PCB на ней хватает пустых мест.

Стабилизатор напряжения графического процессора усилен до шести фаз. Используется ШИМ-контроллер Digi+ ASP1212.

«Сердцем» видеокарты является процессор GK106-400-A1. Кристалл прямоугольной формы, окружен защитной рамкой.

Два гигабайта памяти набраны восемью микросхемами Samsung K4G20325FD-FC03.

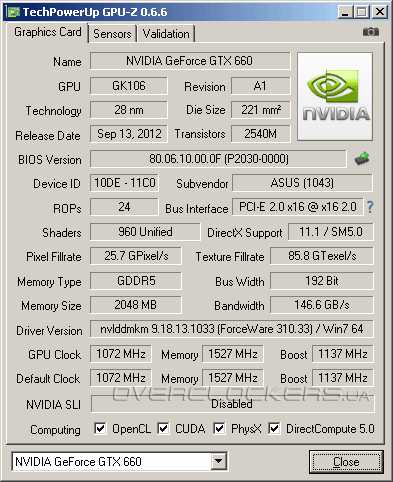

Базовая частота повышена с 980 МГц до 1072 МГц при Turbo Boost 1137 МГц. Приятным моментом является заводской разгон памяти, пускай и совсем незначительный — с 6008 до 6108 МГц. До этого у всех старших видеокарт GeForce от ASUS память обходилась без заводского разгона, хотя для 192-битных и 256-битных решений NVIDIA это вполне актуально.

Согласно GPU-Z параметр ASIC Quality равен 71,1%.

В нашем стандартном 12-минутном тесте Crysis: Warhead графический процессор стабильно работал на частоте в 1176 МГц, что выше результатов разгона, продемонстрированных KFA² GeForce GTX 660 EX и Zotac GTX 660. При этом температура не превышала 66 °С при 23,5 °С в помещении.

В большинстве приложений частота при нагрузке держалась на уровне 1176 МГц. Изредка были просадки в Crysis 2 — до 1110 МГц. В стресс-тесте MSI Kombustor частота держалась в диапазоне 1110—1124 МГц.

Во время тестирования обороты вентиляторов не поднимались выше 2040—2070 об/мин. У ASUS используются столь тихие вентиляторы, что даже на такой скорости их слышно слабо.

Завышенная частота относительно заявленных характеристик свидетельствует о завышенном изначально лимите мощности, это и позволяет GTX660-DC2T-2GD5 все время работать при максимально возможном Boost. Есть еще и небольшой запас для увеличения данного лимита на 10%, что не отличается от возможностей референсного GeForce GTX 660. Итоговый разгон ядра тоже недалеко ушел от результатов других видеокарт этой серии, но все же оказался немного выше. Достигнутая базовая частота составила 1112 МГц при м

www.overclockers.ua

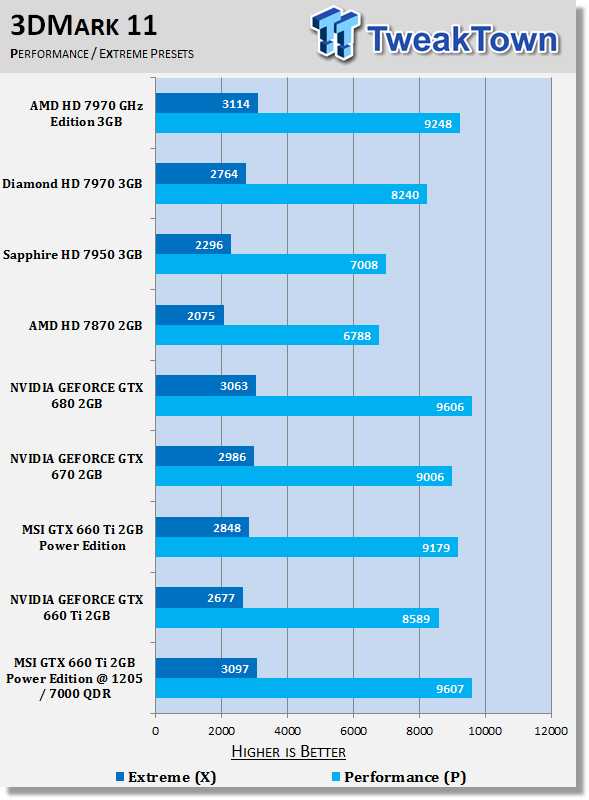

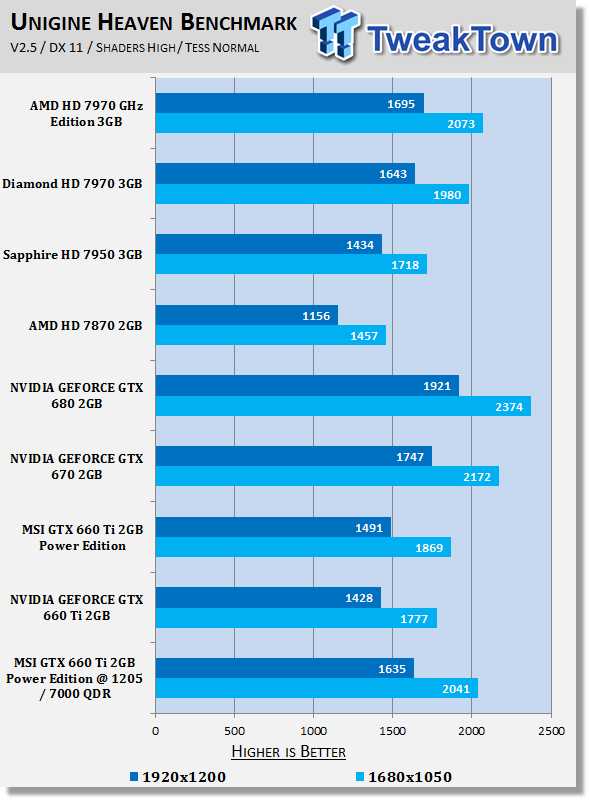

Гоним GTX 660 Ti. Тест MSI GeForce GTX 660 Ti Power Edition OC в разгоне

Я планировал этот материал на четверг, но появились на тот день несколько иные планы, так что предлагаю всем уже сегодня ознакомиться с пересказом обзора с TweakTown, что повествует о ручном разгоне уже знакомой нам видеокарты MSI GeForce GTX 660 Ti Power Edition OC.

Я планировал этот материал на четверг, но появились на тот день несколько иные планы, так что предлагаю всем уже сегодня ознакомиться с пересказом обзора с TweakTown, что повествует о ручном разгоне уже знакомой нам видеокарты MSI GeForce GTX 660 Ti Power Edition OC.

Упаковку видеокарты MSI, ровно как и её саму мы видели вчера, так что переходим к разгону устройства.

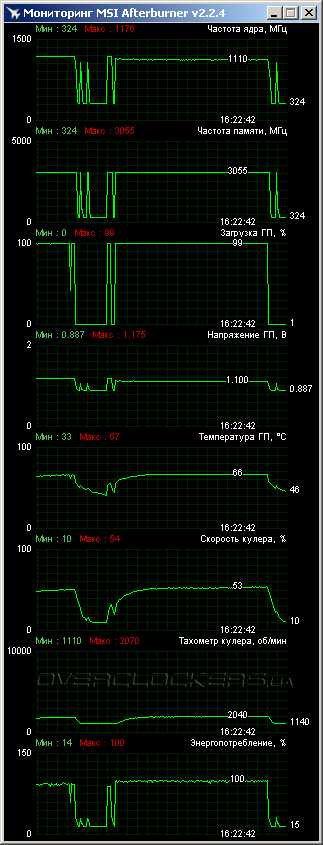

Поглядим на видеокарту глазами утилиты GPU-Z уже после разгона:

Как видно, частоту ядра удалось поднять до 1127МГц (1205МГц в Boost), а памяти — до 7000МГц (эффективных), посмотрим ниже, какой прирост производительности это дало.

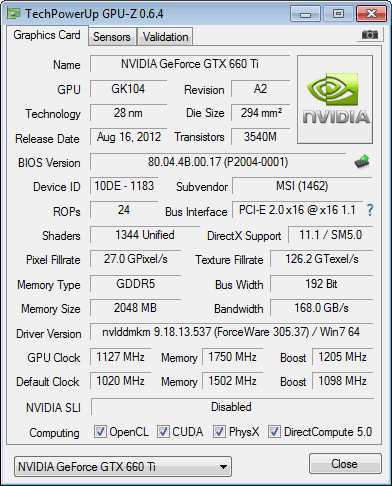

Конфигурация тестового стенда

Давайте вновь полюбуемся мощным конфигом TweakTown:

Автор оригинального материала хочет поблагодарить следующие компании за девайсы, предоставленные для создания тестового стенда: Intel, ASUS и Corsair.

Пришла пора приступить к изучению результатов тестов!

3DMark 11

Используемая версия/установленный патч: 1.1

Web-сайт разработчика: http://www.futuremark.com

Web-сайт продукта: http://www.3dmark.com/3dmark11/

Думаю, что вновь можно обойтись без комментариев, камрады.

Unigine Heaven Benchmark

Используемая версия/установленный патч: 2.5

Web-сайт разработчика: http://www.unigine.com

Web-сайт продукта: http://unigine.com/press-releases/091022-heaven_benchmark//

www.u-sm.ru

Оставить комментарий